Big Data: Lösungen zur Verarbeitung riesiger Datenmengen

TechSpring, Berlin, bietet maßgeschneiderte Lösungen rund um Big Data.

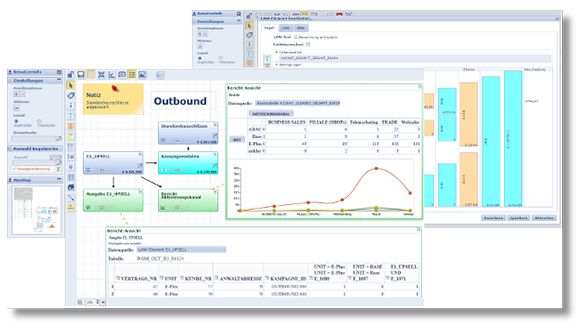

Die den Unternehmen beispielsweise für alle Belange modernen Marketings zur Verfügung stehenden Datenmengen werden immer größer. Entsprechend gestiegen sind damit auch die Anforderungen an die Datenbanken und die erforderliche Software, um diese Datenmengen zu analysieren, zu verarbeiten, zu visualisieren und zu speichern. Traditionelle relationale Datenbanken (engl.: Relational Database Management Systems, RDBMS) sind mit den Anforderungen zeitgemäßer Business Intelligence (BI) wie der Verarbeitung von unstrukturierten Daten, der schnellen Auswertung von sich oft rasch ändernden Informationen (Stichwort „Fast Data“) und der problemlosen Verarbeitung von Datenvolumina im TByte- bzw. PByte-Bereich sehr schnell überfordert bzw. völlig ungeeignet.